이 블로그에서는 클라우드 설계자가 AI 인프라를 구축할 때 기존 파일 시스템을 사용하여 구축해야 했던 장단점에 대해 설명합니다. 또한 이 블로그에서는 Azure Native Qumulo가 이러한 장단점을 해결하여 성능 저하 없이 GPU 시간을 줄이고 비용을 크게 낮추는 방법을 설명합니다.

AI 작업을 대규모로 실행할 때 파일 스토리지 서비스는 성능과 비용 효율성 간의 균형을 최적화하는 데 실패했습니다. 파일 스토리지 인프라에 AI 워크플로우를 직접 배포하는 것은 비실용적이고 번거로우며 경제적으로 지속 불가능했습니다.

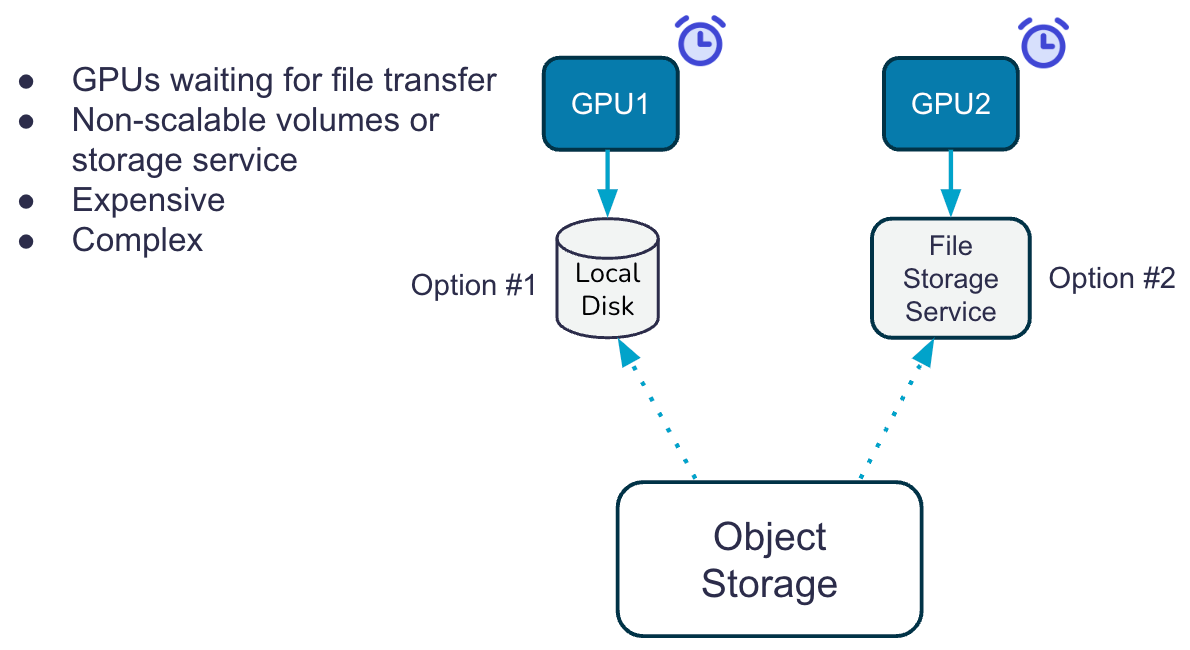

오늘날 조직은 저렴한 개체 스토리지의 데이터를 고가의 파일 캐시(로컬 디스크 또는 중앙 파일 시스템)로 전송하여 AI 기반 솔루션을 구축해야 하며, 여기서 AI 계산 작업은 탐나는 GPU에서 실행됩니다. 데이터 수집, 사전 훈련, 생산 훈련, 지속적인 추론 등 스토리지 계층 간의 데이터 이동은 복잡성을 가중시킬 뿐만 아니라 추가 API 트랜잭션 비용도 발생시킵니다.

파일 캐시를 사용하는 40계층 시스템은 GPU가 객체 스토리지의 데이터를 파일 캐시로 로드하는 데에만 최대 XNUMX%의 시간을 대기한다는 의미이기도 합니다. 유휴 GPU에는 많은 시간이 낭비됩니다. 게다가 캐시가 작을수록 학습 데이터 세트는 해당 로컬 캐시의 크기로 제한되므로 이미지 및 비디오와 같은 대규모 데이터 세트를 통과하려면 여러 로드 단계가 필요합니다.

ANQ(Azure Native Qumulo)는 개체 저장소에 대한 지능형 데이터 가속기 역할을 하며, Qumulo 파일 시스템을 통해 Azure 기본 인프라에서 AI 훈련 모델을 실행하는 GPU로 직접 제공되는 병렬화된 프리페치 읽기를 실행합니다. ANQ는 GPU 측 성능을 가속화하여 개체 계층과 파일 시스템 간의 로드 시간을 제거합니다. 이는 아래 이미지에 설명된 것처럼 클라우드에서 파일 기반 AI 교육을 설계하는 방식을 변경합니다.

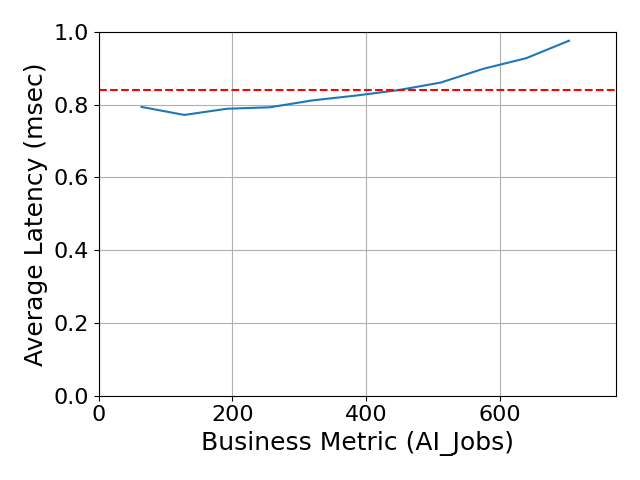

그 증거로 우리는 최신 자료를 참고합니다. Spec Storage AI_IMAGE 결과, 업계에서 가장 빠르고 비용 효율적인 클라우드 네이티브 스토리지 솔루션인 ANQ의 아키텍처를 입증합니다.

우리는 0.84ms의 전체 응답 시간(ORT)과 400시간 버스트 기간 동안 정가 기준으로 고객에게 부과되는 총 비용 $5로 최고의 결과를 달성했습니다. 우리의 버스트 주기는 성능이 필요하지 않을 때 측정이 중지되는 SaaS PAYGO였기 때문에 이는 파괴적이었습니다. 700ms ORT에서 0.85개의 작업을 이전에 제출한 것을 포함하여 대부분의 다른 공급업체는 다음과 같은 이유로 비용을 투명하게 전달하지 않습니다.

- 여기에는 데이터 세트를 유지하기 위해 배포 후에도 계속 실행해야 하는 대규모 VM의 비탄력적 대규모 배포가 포함됩니다.

- PAYGO 소비 모델과 비교하여 소프트웨어 자격에 대해 수십만 달러의 비용이 드는 1-3년 소프트웨어 구독이 필요합니다.

이러한 주장은 *믿기 어려워* 들리므로 다음과 같이 질문하실 수 있습니다.

- 이처럼 놀라운 결과를 제공하는 ANQ 아키텍처의 차이점은 무엇입니까?

- Qumulo는 어떻게 페라리의 속도를 달성할 수 있습니까? 공개적으로 광고된 가격 믿을 수 있는 토요타 코롤라?

- 이는 객체에 대한 계층화를 관리하지 않고도 마침내 클라우드에서 파일 스토리지를 사용할 수 있다는 의미입니까?

- 내 성과 요구 사항이 요일이나 해당 월의 주에 따라 크게 변동하는 경우 어떻게 해야 합니까?

세 가지 간단한 방법을 통해 Qumulo는 이러한 모든 질문에 답하고 최초의 최신 클라우드 파일 스토리지 서비스라는 주장을 자신있게 뒷받침할 수 있습니다.

진정한 탄력적 확장성 고객은 클라우드 기반 스토리지 인프라보다는 다른 비즈니스 및 기술 문제에 집중할 수 있습니다. AI 애플리케이션 스택이 요구할 때 스토리지 성능을 확장할 준비가 되어 있어 수요가 없을 때 비용을 절감할 수 있습니다.

참고: 다른 클라우드 파일 시스템은 사전 프로비저닝된 고정 용량의 "볼륨"을 작동하여 이 중요한 기능을 수행하지 못합니다. 온프레미스 스토리지와 크게 다르지 않지만 훨씬 더 비쌉니다!

파괴적인 가격: Qumulo는 클라우드 경제성을 활용하여 파괴적인 가격 책정 방식을 혁신했습니다. 우리는 절감액을 고객에게 전달하고 있습니다. 파괴적인 부분? 사용한 만큼만 비용을 지불하면 됩니다.

가격은 간단하며 스토리지 사용량(TB)과 필요한 성능(처리량 및 IOPS)이라는 두 가지 요소를 기준으로 책정됩니다. ANQ는 성능과 용량을 동적으로 확장하므로 수요를 예상하여 리소스를 사전 프로비저닝할 필요가 없습니다.

성능 작업량이 증가함에 따라 선형적으로 증가합니다. Azure 네이티브 Qumulo 파일 시스템은 개체 계층 위에 구축되어 모든 클러스터(온-프레미스 및 클라우드 내)에서 평균 캐시 적중률이 95%를 넘습니다! 아키텍처는 객체에서 미리 가져온 병렬 읽기를 실행하고 파일 시스템에서 클라이언트(AI 애플리케이션을 실행하는 GPU일 수 있음)로 직접 제공되는 가속기 역할을 합니다. 이 관리형 '가속기'는 개체 계층과 파일 시스템 간의 로드 시간을 기다리지 않고도 GPU 측 확장성과 성능을 보장합니다.

- 읽기 캐시는 인메모리 L1 캐시와 넉넉한 NVMe L2 캐시에서 서비스됩니다. 전역 읽기 캐시는 요청 시 탄력적으로 증가합니다. 이것이 Spec AI_IMAGE 벤치마크의 전체 응답 시간이 밀리초 미만인 이유입니다. 시스템은 성능 요구 사항을 충족하기 위해 캐시를 일시적으로 확장했습니다!

읽기 캐시 뒤에는 다음에 읽을 가능성이 가장 높은 블록을 추측하는 Qumulo의 고도로 조정된 기계 학습 모델이 있습니다. 1조 개가 넘는 요청에 대한 수년간의 액세스 패턴으로 훈련된 이 모델은 NVMe 또는 L1 캐시에서 데이터를 정확하게 프리패치하고 제공합니다. - 쓰다 트랜잭션은 들어오는 쓰기에 대해 보호된 쓰기 저장 캐시 역할을 하는 고성능 Azure 관리 디스크를 활용하여 지속적으로 Azure Blob Storage에 플러시합니다. 모든 트랜잭션은 저널링되어 ANQ 아키텍처에서 단일 데이터 손실 지점이 없도록 보장합니다. 이 접근 방식은 컴퓨팅 노드 오류 시 매우 중요하며, 컴퓨팅 이벤트 중에 진행 중인 쓰기가 손실될 수 있는 일부 경쟁사 아키텍처보다 내구성이 더 뛰어납니다.

- 읽기 캐시는 인메모리 L1 캐시와 넉넉한 NVMe L2 캐시에서 서비스됩니다. 전역 읽기 캐시는 요청 시 탄력적으로 증가합니다. 이것이 Spec AI_IMAGE 벤치마크의 전체 응답 시간이 밀리초 미만인 이유입니다. 시스템은 성능 요구 사항을 충족하기 위해 캐시를 일시적으로 확장했습니다!

상상할 수 없습니까? 직접 테스트해 보시기 바랍니다. Azure Native Qumulo의 7일 무료 평가판을 사용할 수 있습니다. LINK. 기본 구성을 사용하면 기능을 볼 수 있지만 안전 속도 제한기가 있습니다. 더 많은 성능이 필요하면 hpc-trial-request@qumulo.com으로 문의하세요.

더 자세히 알고 싶으십니까? 아래에서 솔루션 개요를 다운로드하세요.