Este blog explica las ventajas y desventajas que los arquitectos de la nube debían tener en cuenta al utilizar sistemas de archivos tradicionales al construir la infraestructura de IA. El blog también explica cómo Azure Native Qumulo resuelve esas compensaciones, disminuyendo el tiempo de GPU y reduciendo significativamente los costos sin sacrificar el rendimiento.

Cuando se trata de ejecutar operaciones de IA a escala, los servicios de almacenamiento de archivos no han logrado optimizar el equilibrio entre rendimiento y rentabilidad. Implementar flujos de trabajo de IA directamente en la infraestructura de almacenamiento de archivos ha resultado poco práctico, engorroso y económicamente insostenible.

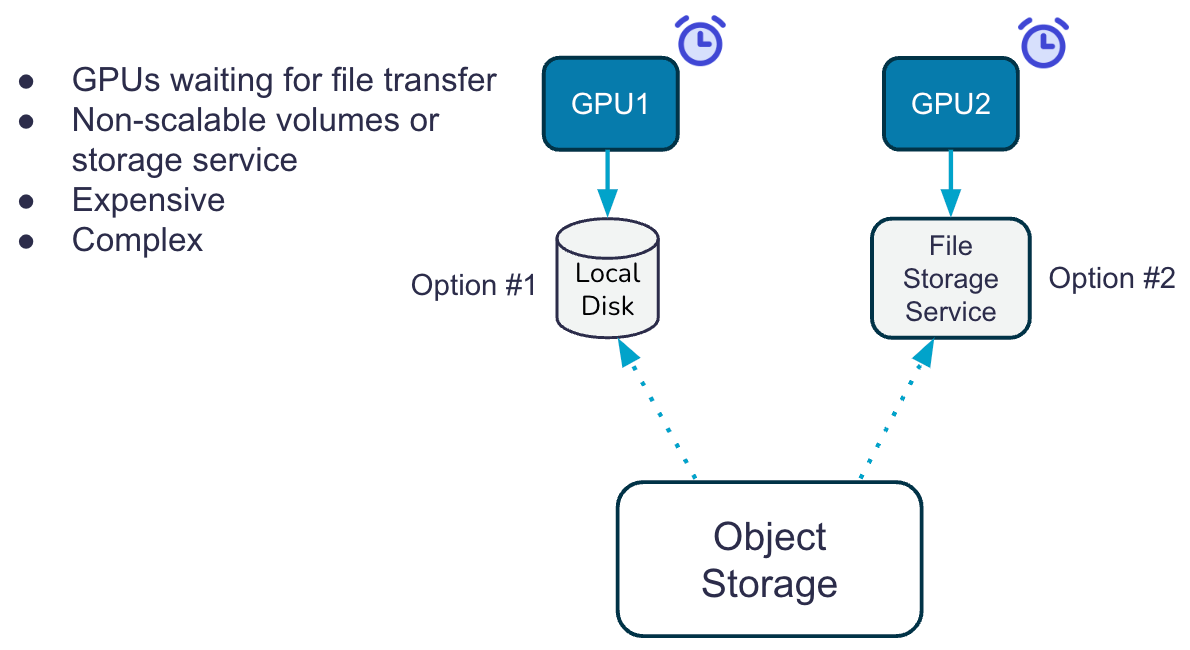

Hoy en día, las organizaciones se ven obligadas a construir soluciones impulsadas por IA transfiriendo datos desde el almacenamiento de objetos de bajo costo a cachés de archivos de alto costo (ya sea disco local o sistemas de archivos centrales), donde las tareas computacionales de IA se ejecutan desde las codiciadas GPU. Ya sea que se trate de recopilación de datos, capacitación previa, capacitación en producción o inferencia continua, el movimiento de datos entre niveles de almacenamiento no solo agrega complejidad sino que también genera tarifas de transacción de API adicionales.

Un sistema de dos niveles que utiliza cachés de archivos también significa que las GPU se mantienen esperando hasta el 40% del tiempo solo para cargar los datos del almacenamiento de objetos en la caché de archivos. Eso es una gran pérdida de tiempo para las GPU inactivas. Y lo que es peor, con las cachés más pequeñas, los conjuntos de datos de entrenamiento están limitados al tamaño de esa caché local, lo que requiere múltiples fases de carga para procesar conjuntos de datos más grandes, como imágenes y videos.

Azure Native Qumulo (ANQ) actúa como un acelerador de datos inteligente para el almacén de objetos, ejecutando lecturas precargadas y paralelizadas servidas directamente desde la infraestructura primitiva de Azure a través del sistema de archivos Qumulo a las GPU que ejecutan modelos de entrenamiento de IA. ANQ acelera el rendimiento del lado de la GPU, eliminando los tiempos de carga entre la capa de objetos y el sistema de archivos. Esto cambia la forma en que se debe diseñar el entrenamiento de IA dependiente de archivos en la nube, como se muestra en la imagen a continuación.

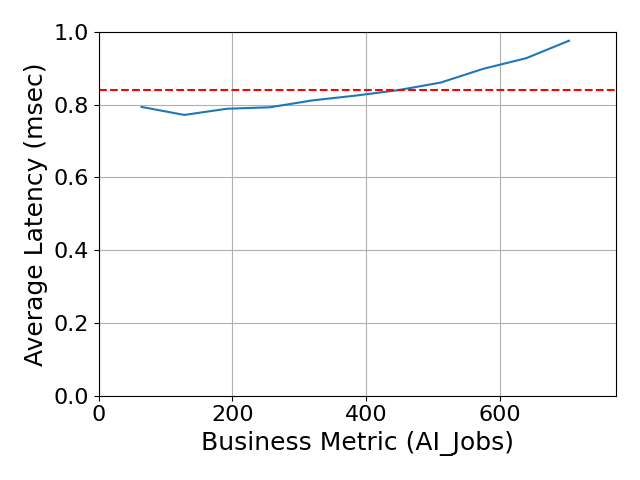

Como prueba, nos remitimos a nuestra última Resultados de almacenamiento de especificaciones AI_IMAGE, lo que demuestra la arquitectura de ANQ como la solución de almacenamiento nativa en la nube más rápida y rentable de la industria.

Logramos el mejor resultado con un tiempo de respuesta general (ORT) de 0.84 ms y un costo total para el cliente de $400 al precio de lista durante un período de ráfaga de 5 horas. Esto es disruptivo porque nuestro ciclo de ráfaga fue completamente SaaS PAYGO, donde la medición se detenía cuando el rendimiento no era necesario. La mayoría de los demás proveedores, incluido un envío anterior de 700 trabajos a 0.85 ms ORT, no comunican los costos de forma transparente porque:

- Incluyen una implementación grande y no elástica de máquinas virtuales de gran tamaño que tendría que seguir ejecutando, incluso después de la implementación, para mantener su conjunto de datos.

- Requieren una suscripción de software de 1 a 3 años, que cuesta cientos de miles de dólares, en un derecho de software en lugar de tener un modelo de consumo de reparto.

Estas afirmaciones *parecen* difíciles de creer, por lo que quizás te preguntes:

- ¿Qué tiene de diferente la arquitectura de ANQ que ofrece resultados tan sorprendentes?

- ¿Cómo puede Qumulo alcanzar la velocidad de un Ferrari, con el precio anunciado públicamente de un Toyota Corolla confiable?

- ¿Significa esto que finalmente puedo usar el almacenamiento de archivos en la nube sin administrar niveles para objetos?

- ¿Qué pasa si mi necesidad de rendimiento fluctúa enormemente según el día de la semana o la semana del mes?

Tres cosas simples permiten a Qumulo responder todas estas preguntas y respaldar con confianza nuestra afirmación como el primer servicio moderno de almacenamiento de archivos en la nube.

Verdadera escalabilidad elástica permite a los clientes centrarse en otras preocupaciones comerciales y tecnológicas en lugar de en la infraestructura de almacenamiento nativa de la nube. El rendimiento del almacenamiento está listo para escalar cuando la pila de aplicaciones de IA lo exige, lo que ahorra costos cuando no hay demanda.

Nota: Otros sistemas de archivos en la nube fallan en esta capacidad crítica al operar “volúmenes” de capacidad fija previamente aprovisionados. En realidad no es diferente del almacenamiento local, ¡pero es mucho más caro!

Precios disruptivos: Qumulo ha innovado para lograr precios disruptivos, aprovechando la economía de la nube; Estamos pasando los ahorros al cliente. ¿La parte disruptiva? solo paga por lo que usas.

El precio es simple y se basa en dos factores: uso de almacenamiento (TB) y rendimiento necesario (rendimiento e IOP); ANQ escala el rendimiento y la capacidad de forma dinámica para que no haya necesidad de aprovisionar recursos previamente en previsión de la demanda.

Rendimiento aumenta linealmente a medida que aumenta su carga de trabajo. El sistema de archivos Azure Native Qumulo está construido sobre el nivel de objetos, lo que logra una tasa promedio de aciertos de caché en todos los clústeres (locales y en la nube) superior al 95 %. La arquitectura actúa como un acelerador que ejecuta lecturas en paralelo que se obtienen previamente del objeto y se envían directamente desde el sistema de archivos a sus clientes, que pueden ser GPU que ejecutan aplicaciones de IA. Este 'acelerador' administrado garantiza la escalabilidad y el rendimiento del lado de la GPU sin tener que esperar tiempos de carga entre la capa de objetos y el sistema de archivos.

- Leer El caché se alimenta desde un caché L1 en memoria y un generoso caché NVMe L2. La caché de lectura global aumenta según demanda y de forma elástica. Es por eso que tuvimos un tiempo de respuesta general inferior a un milisegundo para el punto de referencia Spec AI_IMAGE; ¡El sistema amplió el caché temporalmente para cumplir con los requisitos de rendimiento!

Detrás del caché de lectura se encuentra el modelo de aprendizaje automático altamente optimizado de Qumulo que adivina qué bloques tienen más probabilidades de leerse a continuación. Entrenado con años de patrones de acceso de más de 1 billón de solicitudes, el modelo busca previamente y proporciona datos con precisión desde la caché NVMe o L1. - Escribe. Las transacciones aprovechan los discos administrados de Azure de alto rendimiento, que actúan como una caché de reescritura protegida para las escrituras entrantes y las descargan continuamente en Azure Blob Storage. Cada transacción se registra en un diario, lo que garantiza que no haya ningún punto único de pérdida de datos en la arquitectura ANQ. Este enfoque es fundamental durante las fallas de los nodos de cómputo y es más duradero que la arquitectura de algunas de nuestras competidores, donde las escrituras en tránsito pueden perderse durante eventos de cómputo.

- Leer El caché se alimenta desde un caché L1 en memoria y un generoso caché NVMe L2. La caché de lectura global aumenta según demanda y de forma elástica. Es por eso que tuvimos un tiempo de respuesta general inferior a un milisegundo para el punto de referencia Spec AI_IMAGE; ¡El sistema amplió el caché temporalmente para cumplir con los requisitos de rendimiento!

¿Inconcebible? Te invitamos a probarlo por ti mismo. Puede realizar una prueba gratuita de 7 días de Azure Native Qumulo aquí. La configuración predeterminada le permitirá ver la funcionalidad, pero tiene un limitador de tasa de seguridad. Si necesita más rendimiento, comuníquese con hpc-trial-request@qumulo.com.

¿Interesado en aprender más? Descargue nuestro resumen de solución a continuación.