Eine Ära von beispiellosem Datenumfang

Die grundlegende Art und Weise, wie Unternehmen Computer nutzen, um Innovation, Agilität und Reaktionsfähigkeit voranzutreiben, hat sich in den letzten fünf Jahren erheblich verändert. Während sich Unternehmen in der Vergangenheit auf Daten verlassen haben, um ihr Geschäft voranzutreiben, war die Beschaffung und Speicherung dieser Daten oft teuer.

In den letzten fünf Jahren haben wir eine drastische Reduzierung der Wirtschaftlichkeit der Datenerstellung und eine ebenso dramatische Reduzierung der Kosten für die Datenspeicherung festgestellt. Wir haben uns aus der Ära der „Wie speichere ich Daten?"To"Wie verwalte ich Daten intelligent und effizient?„Außerdem befinden wir uns in einer Zeit, in der Milliarden von Dateien – oder mehr – die Norm sind.

Dies ist die Ära eines beispiellosen Datenumfangs. Diese Daten werden von dateibasierten Anwendungen und Systemen erzeugt und konsumiert, die die Grundlage moderner digitaler Produktionspipelines bilden. Damit generieren Unternehmen heute deutlich mehr dateibasierte Daten als je zuvor.

Infolgedessen wachsen Unternehmen schnell aus ihren veralteten Dateisystemen heraus und können ihre riesigen Sammlungen digitaler Assets nicht mehr verwalten. Diese Assets bleiben jedoch das Herzstück des Geschäfts, und dateibasierte Workflows sind die entscheidenden Pipelines für diese Assets.

In der heutigen Welt der Fülle an Daten gibt es keine Begrenzung für die Anzahl der Dateien – Milliarden oder Billionen von Dateien sind nicht nur möglich, sondern alltäglich. Es gibt auch keine Begrenzung der Dateigröße im Extremfall – klein und groß, und keine Begrenzung der Verfügbarkeit, ob vor Ort, in der Cloud oder in geografisch verteilten Rechenzentren.

Der Übergang vom Großmaßstab zum Hypermaßstab

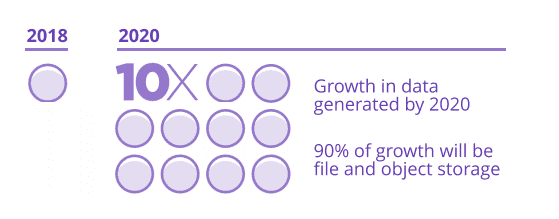

IDC prognostiziert, dass die erzeugte Datenmenge bis 40 2020 Zettabyte (ein Zettabyte ist eine Milliarde Terabyte) erreichen wird, und dass es mehr als . sein werden 163 Zettabyte bis 2025. Das ist das Zehnfache der im Jahr 2016 generierten Daten.

Ungefähr 90 Prozent dieses Wachstums entfallen auf Datei- und Objektspeicher.

Es gibt vier Trends, die zu der Menge an Daten beitragen, die Unternehmen speichern müssen:

- Die enorme Zunahme maschinengenerierter Daten;

- Die Verbreitung von Video als Datentyp in allen Branchen;

- Die ständig steigende Auflösung und Wiedergabetreue dieser digitalen Assets und

- Längere Datenlebensdauern und Trends zur Globalisierung, die verteilte Rechen- und Speicherressourcen schaffen.

Maschinengenerierte Daten

Erfolgreiche Unternehmen verlassen sich zunehmend auf maschinengenerierte Daten für Kerngeschäftsvorgänge und Einblicke. Das Internet der Dinge (IoT) treibt den Wert von Daten für Unternehmen aller Art in allen datenintensiven Branchen um.

Daten treiben Wert und Wachstum wie nie zuvor an. Zum Beispiel groß maschinell generierte Datensätze in den Life Sciences machen bahnbrechende Entdeckungen und lebensrettende medizinische Behandlungen verfügbar. Aufgrund ihres enormen Wertes für Forscher, Gesundheitsdienstleister und Patienten wird der Bedarf an solchen Daten nur zunehmen.

Als weiteres Beispiel nutzen Öl- und Gasunternehmen Daten, um für ihre Kunden einen enormen Mehrwert zu schaffen. Es ist nicht übertrieben zu sagen, dass die größten Vorteile für diese Organisationen die dateibasierten seismischen Daten sind, die für die Entdeckung von Erdgas und Öl verwendet werden.

Digitale Assets mit höherer Auflösung

Technische Fortschritte bei Hard- und Softwaresystemen ermöglichen neue Möglichkeiten für Unternehmen aller Art.

Zum Beispiel können Medien- und Unterhaltungsunternehmen jetzt rund um standardisieren unkomprimiertes 4K-Video, mit 8K am Horizont. Noch vor wenigen Jahren war ein solches Maß an Wiedergabetreue für wirklich immersive Seherlebnisse undenkbar.

Auch die Auflösung digitaler Sensoren und wissenschaftlicher Geräte nimmt stetig zu. Eine höhere Auflösung führt dazu, dass die Dateigröße mehr als linear anwächst – eine Verdoppelung der Auflösung eines digitalen Fotos beispielsweise erhöht seine Größe um das Vierfache.

Da die Welt mehr Wiedergabetreue von digitalen Assets verlangt, wächst ihr Speicherbedarf.

Längere Datenlebensdauer

Gleichzeitig hat das Aufkommen des maschinellen Lernens völlig neue Wertschöpfungsquellen für Unternehmen und ihre Kunden ermöglicht. Es ist jetzt möglich, Millionen oder Milliarden von Einzeldaten zu nutzen und Systeme Muster, Wertquellen, Chancen- und Risikobereiche identifizieren zu lassen, die zuvor einfach nicht möglich waren. Diese enormen Fortschritte in der Datenanalyse und beim maschinellen Lernen machen Daten im Laufe der Zeit wertvoller.

Für Unternehmen bedeutet dies eine enorme Belastung für ihre Anwendungen und den Speicher, von dem diese Anwendungen abhängen. Unternehmen müssen sich an die neue Landschaft der Möglichkeiten anpassen und sind gezwungen, in Bezug auf ihre Daten zu einer Philosophie „Besser behalten, als sie später zu verpassen“ gezwungen.

Die Public Cloud hat die Art und Weise, wie Anwendungen erstellt und bereitgestellt werden, verändert. Die Trends hin zu Unternehmen, die ihren Kunden aus massiven Datenbeständen und der Entwicklung ausgeklügelter Analysetools einen enormen Mehrwert bieten, gingen einher mit dem Aufkommen der Public Cloud. Seine Ankunft hat grundlegende Annahmen über die Art und Weise, wie Computing durchgeführt werden könnte und wie Speicher funktionieren sollte, umgeworfen.

Dies hat nicht nur das Tempo der geschäftlichen Innovation grundlegend verändert, sondern auch, wer dieses Tempo vorgibt. Die Leichtigkeit, mit der Geschäftsbereichsleiter Daten erstellen und verwalten und Anwendungen bereitstellen können, um diese Daten zu nutzen, belastet viele Technologieorganisationen, die Unternehmen unterstützen.

Globale Reichweite

Die Cloud bedeutet, dass Führungskräfte Innovationen und Mehrwert für ihre Kunden schneller und effizienter vorantreiben und gleichzeitig Ressourcen nutzen können, die sich elastisch verhalten.

Die Verlagerung von investitions- zu opex-basierten Technologieausgaben hat die Entscheidungsfindung und das Innovationstempo von zentralisierten Technologieorganisationen auf Unternehmensmanager verlagert. Dies hat zu einer schnellen Einführung neuer Technologien geführt, die durch den elastischen Zugriff auf die für deren Bereitstellung erforderlichen Rechenressourcen ermöglicht werden. Und diese Elastizität erstreckt sich auf geografische Regionen, sodass eine globale Reichweite ohne den Bau physischer Rechenzentren auf der ganzen Welt erreichbar ist.

Neue Wege zur Lösung von Problemen und zur Bereitstellung von Kundennutzen sind eingetroffen und werden es bleiben. Alle Unternehmen wissen, dass sie ihre Workloads in Zukunft nicht mehr in einzelnen, selbstverwalteten Rechenzentren ausführen werden.

Stattdessen werden sie in mehrere Rechenzentren umziehen, von denen sich eines oder mehrere in der Public Cloud befinden. Diese Flexibilität hilft ihnen, sich an eine Welt mit verteilten Mitarbeitern und Geschäftspartnern anzupassen.

Unternehmen werden ihre Ressourcen auf ihre Kerngeschäftsbereiche statt auf IT-Ausgaben konzentrieren. Die meisten werden ihre Pläne für Notfallwiederherstellung und Geschäftskontinuität verbessern, und viele werden dies tun, indem sie die Elastizität der Cloud nutzen.

Die disruptive Realität der Dateispeicherung fordert Unternehmen heraus, neue Lösungen und Ansätze für ihre dateibasierten Workflows und Assets zu finden.

Die Herausforderung für Speicherlösungen

Benutzer von Anwendungen, die von älteren Scale-up- und Scale-out-Dateisystemen abhängig sind – den traditionellen Arbeitspferden dateibasierter Daten – finden diese Systeme für die heutige elastische Computerrealität und ihr zukünftiges Potenzial ungeeignet.

Eine der Hauptherausforderungen ist die Unfähigkeit, die Natur Ihrer Daten zu verstehen. sein Wert erreicht eine kritische Grenze, die von Legacy-Systemen auferlegt wird. Diese Einschränkung wirkt sich darauf aus, wie Altsysteme die Metadaten großer Dateisysteme verwalten – ihre Verzeichnisstrukturen und Dateiattribute werden selbst zu Big Data.

Legacy-Lösungen, die auf Brute-Force angewiesen sind, um Einblicke in das Speichersystem zu geben, wurden durch die Skalierung besiegt. Brute-Force-Methoden sind grundlegend für den Entwurf von Legacy-Dateisystemen und können nicht mit Patches behoben werden.

Eine weitere Einschränkung, die die Leistung von Legacy-Systemen in dieser neuen elastischen Welt verhindert, besteht darin, dass sie nie für eine „elastische“ Skalierung entwickelt wurden, d. h. die Skalierung über kleine und große Dateigrößen sowie geografische Standorte.

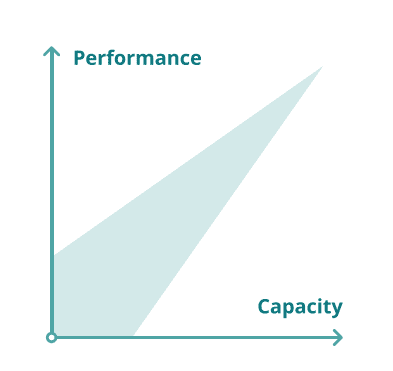

Traditionell standen Unternehmen bei der Bereitstellung dateibasierter Speichersysteme vor zwei Problemen: Sie mussten sowohl die Kapazität als auch die Leistung skalieren.

Mit der elastische Lagerung, Kapazität bedeutet mehr als die Erstellung eines großen Repositorys mit Terabyte an Rohspeicher. In der heutigen Welt, in der alle Daten wertvoll sind, ist die Skalierung nicht mehr auf diese beiden Achsen beschränkt.

Neue Maßstabskriterien sind aufgetaucht. Dazu gehören die Anzahl der gespeicherten Dateien, die Möglichkeit, enorme Datenbestände in Echtzeit zu kontrollieren, die globale Verteilung von Daten und die Flexibilität, Elastic Computing in der Public Cloud auch über das Rechenzentrum hinweg zu nutzen.

Vor diesem Hintergrund tiefgreifender Disruption haben die traditionellen Kaufkriterien nicht an Relevanz verloren. Preis, Leistung, Benutzerfreundlichkeit und Zuverlässigkeit sind nach wie vor wichtig, egal wie sehr sich die Landschaft entwickelt hat.

Heutige sich verändernde Speicherlandschaft stellt Unternehmenskunden an einen Scheideweg. Sie werden Schwierigkeiten haben, mit riesigen Datenmengen fertig zu werden. Sie werden Schwierigkeiten haben, die Anforderungen an eine globale Reichweite zu erfüllen, da es nur wenige gute Optionen für dateibasierte Daten gibt, die das Rechenzentrum und die öffentliche Cloud umfassen.

Lösungsversuche: Objekt und Unterteilung nach Volumen

Verständlicherweise gab es inkrementelle Versuche, diesen wachsenden Bedarf an elastischer Dateispeicherung in großem Maßstab zu decken. Aus den unten aufgeführten Gründen sind diese Ansätze jedoch architektonisch nicht ausreichend, um die erheblichen Anforderungen von elastischem Speicher und die Anforderungen von Unternehmen in diesem Zeitalter des elastischen Speichers zu erfüllen.

Objektspeicher

Objektspeicher ermöglicht sehr große Systeme mit Petabytes an Daten und Milliarden von Objekten und funktioniert gut für den vorgesehenen Zweck. Tatsächlich ist es mittlerweile allgemein üblich, zu behaupten, dass Objektspeichertechnologien die Lösung für die Herausforderungen der Größe und der Geoverteilung von unstrukturiertem Speicher sind.

Cloud-Anbieter glauben von ganzem Herzen an Objektspeicher. Heutzutage ist ein Kunde, der Daten in der Cloud speichern möchte, praktisch gezwungen, diese unabhängig vom Anwendungsfall zu verwenden.

Einige Unternehmen versuchen, Objektspeicher in Anwendungsfällen einzusetzen, für die er nie gedacht war und für die er schlecht geeignet ist. Um ihre Skalierungs- und Geoverteilungseigenschaften zu erreichen, haben Objektspeicher bewusst auf Funktionen verzichtet, die viele Benutzer benötigen und erwarten: Transaktionskonsistenz, Modifikation von Objekten (z. B. Dateien), feingranulare Zugriffskontrolle und Verwendung von Standardprotokollen wie NFS und SMB, um nur einige zu nennen.

Die Objektspeicherung lässt auch das Problem der Organisation von Daten unbehandelt. Stattdessen wird den Benutzern empfohlen, die Daten selbst in einer Art externer Datenbank zu indizieren. Dies mag für den Speicherbedarf von eigenständigen Anwendungen ausreichen, erschwert jedoch die Zusammenarbeit zwischen Anwendungen und zwischen Menschen und diesen Anwendungen.

Moderne Workflows beinhalten fast immer Anwendungen, die unabhängig entwickelt wurden, aber durch den Austausch dateibasierter Daten zusammenarbeiten, ein Interop-Szenario, das mit Objektspeicher einfach nicht möglich ist. Außerdem bieten Objektspeicher nicht die Vorteile eines Dateisystems für die Governance.

Unterteilung in Bände

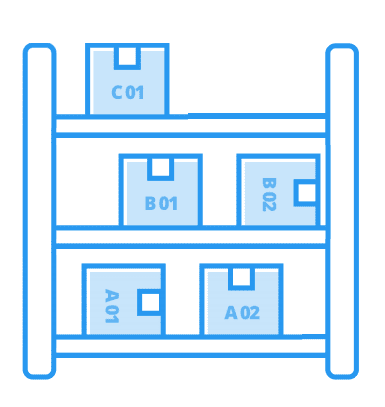

Ein anderer Ansatz zum Umgang mit großen Datenmengen auf Legacy-Dateisystemen besteht darin, die Dateien in separate Volumes zu partitionieren, was mehrere Namespaces bedeutet. Volumes sind Silos von Dateidaten.

Separate Volumes bedeuten immer verschwendeten Speicherplatz. Jedes Volume enthält Reservekapazität, und wenn Sie die gesamte Reservekapazität aller Volumes addieren, haben Sie eine beträchtliche Menge an vergeudeter Kapazität.

Getrennte Volumen bedeuten Ineffizienz, die sich in höheren Speicher- und Infrastrukturkosten niederschlägt.

Zusammenarbeit ist für viele dateibasierte Workflows von grundlegender Bedeutung, kann jedoch nur erfolgen, wenn jeder Zugriff auf die Daten hat. Da Volumes isolierte Datensilos bilden, müssen Informationen von einem Silo in ein anderes kopiert werden, was sowohl zeitaufwändig als auch umständlich ist.

In einer einzelner Namensraum System gibt es ein zentrales Speicher-Repository, auf das jeder mit den richtigen Berechtigungen zugreifen kann.

Ein einziger Namensraum ermöglicht Kollaboration und Kooperation.

Ansätze mit mehreren Volumes können die Skalierbarkeit der Leistung des Dateisystems einschränken, da Administratoren den Durchsatz bestimmten Volumes zuweisen müssen. Dadurch können hohe Verkehrsaufkommen zu Engpässen werden. Mit einem einzigen Namespace wird der Gesamtdurchsatz auf eine breitere Gruppe von Benutzern und Anwendungen verteilt, wodurch die Gefahr von Engpässen verringert wird.

Es ist schwierig, separate Volumes in Bezug auf Berechtigungen, Kapazitätsplanung, Benutzer- oder Projektkontingente, Backups und andere Aufgaben zu verwalten, da Administratoren eine fragmentierte Sicht auf das Dateisystem haben. Ein einzelner Namespace bietet eine einheitliche Ansicht, wodurch es viel einfacher wird, zu sehen, wie das Dateisystem verwendet wird.

Elastisches Speicher-Datei-Fabric ermöglicht eine flexible Nutzung des Dateispeichers

Elastischer Dateispeicher skaliert in Milliardenhöhe und Billionen von Dateien.

Die Vorstellung, dass Kapazität nur in Bytes des Rohspeichers gemessen wird, weicht einem breiteren Verständnis, dass Kapazität ebenso oft durch die Anzahl der digitalen Assets definiert wird, die gespeichert werden können. Moderne dateibasierte Workflows umfassen eine Mischung aus großen und kleinen Dateien, insbesondere wenn sie eine beliebige Menge maschinell generierter Daten beinhalten.

Da veraltete Dateisysteme an die Grenzen digitaler Assets stoßen, die sie effektiv speichern können, können Käufer nicht mehr davon ausgehen, dass sie über eine ausreichende Dateikapazität verfügen.

Der elastische Dateispeicher lässt sich über Betriebsumgebungen hinweg skalieren, einschließlich der öffentlichen Cloud. Proprietäre Hardware ist für Benutzer von großen Dateispeichern zunehmend eine Sackgasse. Moderne Unternehmen brauchen Flexibilität und Auswahl. Sie möchten Dateien in Rechenzentren und in der öffentlichen Cloud speichern und entscheiden sich für das eine oder andere nur aufgrund von Geschäftsentscheidungen und nicht aufgrund technischer Einschränkungen ihrer Speicherplattform.

Unternehmen wollen von den rasanten technischen und wirtschaftlichen Fortschritten der Standardhardware profitieren, einschließlich dichterer Laufwerke und kostengünstigerer Komponenten. Sie wollen die Komplexität der Hardwarewartung durch Standardisierung und optimierte Konfigurationen reduzieren.

Der Trend, dass intelligente Software auf Standardhardware die proprietäre Hardware überholt, wird nur noch zunehmen.

Benutzer von großen Dateispeichern erfordern, dass ihre Speichersysteme in einer Vielzahl von Betriebsumgebungen ausgeführt werden und nicht an proprietäre Hardware gebunden sind.

Ein elastisches Aktengewebe ermöglicht eine flexible Nutzung des Aktenspeichers. Ein flexibles On-Demand-Nutzungsmodell ist ein Markenzeichen der Public Cloud. Die Umstellung auf die Cloud hat jedoch Benutzer von groß angelegten Dateispeichern gestrandet, die keine effektive Möglichkeit haben, die Leistungsfähigkeit der Cloud zu nutzen.

Eine elastische Dateistruktur lässt sich mit Datenmobilität über geografische Standorte hinweg skalieren. Unternehmen sind zunehmend global. Ihre dateibasierten Speichersysteme müssen nun über geografische Standorte hinweg skalieren. Dies kann mehrere Rechenzentren und mit ziemlicher Sicherheit die Public Cloud betreffen.

Ein stückweiser Ansatz und ein Etikett mit der Aufschrift „CLOUD-READY“ werden nicht funktionieren. Echte Mobilität und geografische Reichweite sind jetzt gefragt.

Ein elastisches Feilengewebe bietet Sichtbarkeit und Kontrolle in Echtzeit. Da Sammlungen digitaler Assets bis auf eine Milliarde Dateien angewachsen sind, ist die Möglichkeit, Speicherressourcen in Echtzeit zu kontrollieren, zu einer dringenden neuen Anforderung geworden.

Speicheradministratoren müssen in der Lage sein, alle Aspekte der Leistung und Kapazität zu überwachen, unabhängig von der Größe des Speichersystems.

Ein elastisches Feilengewebe ermöglicht den Zugang zu schneller Innovation.

Moderne Dateispeicherung braucht ein einfaches, elegantes Design und fortschrittliche Technik. Unternehmen, die moderne Dateispeicher entwickeln wird agile Entwicklungsprozesse verwenden, die schnelle Release-Zyklen und den kontinuierlichen Zugang zu Innovationen betonen. Dreijährige Update-Zyklen sind ein Relikt der Vergangenheit, das Kunden nicht länger tolerieren können.

Elastisches Gewebe ist die Zukunft der Dateispeicherung

Dateibasierte Daten werden transformativ, wenn sie den Menschen die Freiheit geben, zusammenzuarbeiten, zu erneuern und zu kreieren. Es fördert das Wachstum und die langfristige Rentabilität moderner, datenintensive Unternehmen.

Dateibasierte Daten sind wichtiger denn je und Unternehmen müssen bessere Wege finden, um auf diese Daten zuzugreifen und sie zu verwalten. Um dieser Herausforderung zu begegnen, müssen Unternehmen moderne Dateisystemtechnologien einsetzen, die eine elastische Dateistruktur ermöglichen.

Verlässlichkeit, hohe Kapazität und Leistung sind Tischeinsätze. Darüber hinaus benötigen Unternehmen globalen Zugriff und elastische Skalierbarkeit, einschließlich der Möglichkeit, auf Milliarden von Dateien zu skalieren. Das Dateispeichersystem muss Daten dorthin verschieben, wo sie benötigt werden, wann immer sie benötigt werden, und dies alles zu geringeren Kosten, höherer Leistung, mehr Zuverlässigkeit und einfacherer Handhabung als bei Legacy-Systemen.

Elastic Fabric ist die Zukunft der Dateispeicherung für Unternehmen, die im digitalen Zeitalter wettbewerbsfähig, innovativ und agil bleiben.